Najnowsze badania Google DeepMind wprowadzaj? struktur? oceny, która systematycznie analizuje, w jaki sposób AI wp?ywa na efektywno?? istniej?cych technik ataku. Celem jest lepsze przygotowanie zespo?ów ds. bezpiecze?stwa na pojawiaj?ce si? zagro?enia.?

Analiza wp?ywu AI na techniki ataku

Struktura oceny opracowana przez Google DeepMind sk?ada si? z czterech kluczowych etapów:?

- Wybór reprezentatywnych ?a?cuchów ataków: Identyfikacja typowych scenariuszy ataków, takich jak phishing, ataki DDoS czy exploity zero-day.?

- Analiza w?skich garde?: Okre?lenie, które etapy w ?a?cuchu ataku mog? zosta? usprawnione przez zastosowanie SI, czyni?c je bardziej efektywnymi.?

- Opracowanie testów porównawczych: Tworzenie benchmarków do mierzenia wydajno?ci SI w zidentyfikowanych fazach ataku.?

- Ocena wp?ywu: Szacowanie potencjalnych oszcz?dno?ci kosztów dla atakuj?cych w ca?ym ?a?cuchu ataku .?

Testy przeprowadzone z modelem Gemini 2.0 wykaza?y, ?e AI przede wszystkim zwi?ksza skal? i szybko?? ataków. Nowe techniki ataku pojawiaj? si? rzadko, ale istniej?ce metody staj? si? bardziej skuteczne dzi?ki zastosowaniu AI. Szczególnie dobrze AI radzi sobie w zadaniach takich jak eksploracja, unikanie wykrycia oraz utrzymanie dost?pu .?

Implikacje dla obrony cybernetycznej

Wnioski p?yn?ce z tej analizy s? kluczowe dla strategii obronnych organizacji:

- Zwi?kszona skuteczno?? AI w fazie instalacji oraz komunikacji dowodzenia i kontroli: Wymaga to wdro?enia bardziej zaawansowanych mechanizmów wykrywania i reagowania na te etapy ataku.?

- Realistyczne testy penetracyjne z wykorzystaniem AI: Struktura mo?e pos?u?y? jako podstawa do przeprowadzania symulacji ataków z u?yciem SI, co pozwoli na lepsze przygotowanie zespo?ów ds. bezpiecze?stwa .?

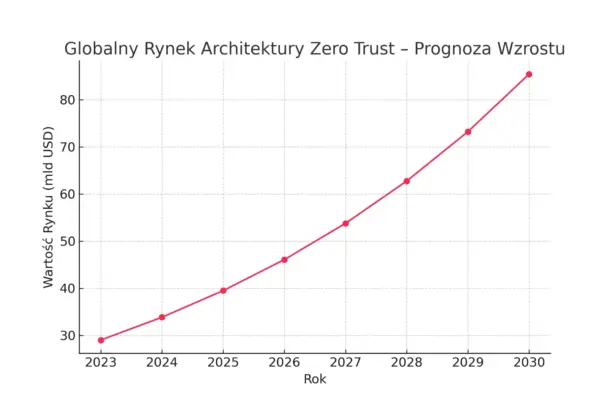

Indeks cyberinflacji jako nowa miara ryzyka

Jednym z interesuj?cych pomys?ów przedstawionych przez Google DeepMind jest koncepcja “indeksu cyberinflacji”. Mia?by on ilustrowa?, w jaki sposób AI obni?a ekonomiczne bariery dla przeprowadzania cyberataków, redukuj?c potrzebny czas i specjalistyczn? wiedz?. Taka miara mog?aby pomóc w kwantyfikacji ryzyka zwi?zanego z rozwojem AI w kontek?cie cyberbezpiecze?stwa .?

Szerszy kontekst zagro?e? zwi?zanych z AI

Nale?y równie? zwróci? uwag? na inne potencjalne zagro?enia wynikaj?ce z rozwoju AI:?

- Wykorzystanie AI do tworzenia broni biologicznych i bomb: Istniej? obawy, ?e zaawansowane modele generatywne mog? zosta? wykorzystane do projektowania niebezpiecznych substancji czy urz?dze?.

- Manipulacja opini? publiczn?: AI mo?e by? u?ywana do tworzenia zaawansowanych kampanii dezinformacyjnych, co stanowi zagro?enie dla procesów demokratycznych.?

Rozwój sztucznej inteligencji niesie ze sob? zarówno ogromne mo?liwo?ci, jak i powa?ne wyzwania w zakresie cyberbezpiecze?stwa. Struktura oceny zaproponowana przez Google DeepMind dostarcza cennych narz?dzi do zrozumienia i przeciwdzia?ania wp?ywowi AI na techniki ataku. Jednak?e, aby skutecznie chroni? si? przed ewoluuj?cymi zagro?eniami, konieczne jest ci?g?e monitorowanie, adaptacja strategii obronnych oraz mi?dzynarodowa wspó?praca w zakresie regulacji i standardów bezpiecze?stwa.?