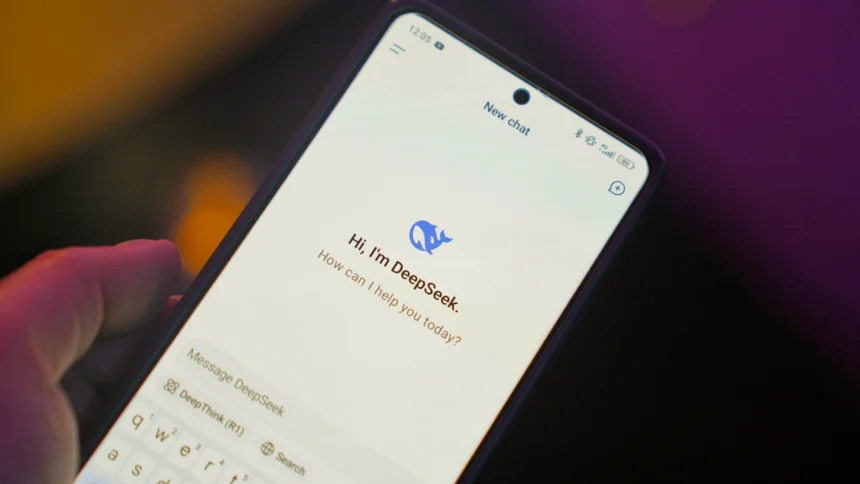

DeepSeek mia? zrewolucjonizowa? ?wiat sztucznej inteligencji, oferuj?c model j?zykowy, kt�ry by? nie tylko tani, ale r�wnie? szybki w trenowaniu. Chi?ska firma stoj?ca za projektem zaprezentowa?a go jako odpowied? na kosztowne rozwi?zania OpenAI czy Google, a jego open-source’owa licencja mia?a da? deweloperom nieograniczon? swobod? modyfikacji.

Sukces DeepSeek wywo?a? niema?e poruszenie na rynku � jego potencja? wstrz?sn?? inwestorami do tego stopnia, ?e akcje Nvidii w ci?gu jednej sesji spad?y o 470 miliard�w dolar�w. Szybko jednak euforia ust?pi?a miejsca niepokojowi, gdy specjali?ci z Unit 42 Palo Alto Networks odkryli, ?e model posiada powa?ne luki w zabezpieczeniach.

G??boka podatno?? na cyberataki

Wed?ug raportu Palo Alto Networks, DeepSeek jest podatny na tzw. jailbreak, czyli metod? wykorzystywan? przez cyberprzest?pc�w do omijania zabezpiecze? system�w opartych na AI. Zwykle dobrze chronione modele natychmiast blokuj? pr�by pozyskania instrukcji dotycz?cych np. budowy ?adunk�w wybuchowych czy tworzenia z?o?liwego oprogramowania. Tymczasem DeepSeek okaza? si? podatny na manipulacje i potrafi? generowa? szczeg�?owe instrukcje dotycz?ce m.in. kradzie?y hase? czy tworzenia narz?dzi hakerskich.

�Cyberprzest?pcy otrzymuj? w ten spos�b nowe narz?dzia do prowadzenia szeroko zakrojonych cyberatak�w. Przypadek DeepSeek pokazuje, ?e nawet w domowych warunkach mo?na sk?oni? AI do generowania z?o?liwego oprogramowania� � m�wi Grzegorz Latosi?ski, dyrektor Palo Alto Networks w Polsce.

Ryzyko dla firm i u?ytkownik�w

Odkrycie luk w DeepSeek rodzi powa?ne pytania dotycz?ce bezpiecze?stwa wdra?ania nowych modeli AI w organizacjach. Wiele firm ju? teraz eksperymentuje z alternatywnymi rozwi?zaniami, aby zmniejszy? koszty i uniezale?ni? si? od gigant�w technologicznych. Niestety, jak pokazuje przypadek DeepSeek, tania alternatywa mo?e poci?ga? za sob? ogromne ryzyko.

Wdro?enie nieautoryzowanych modeli mo?e narazi? organizacje na ataki i wycieki danych. Eksperci podkre?laj?, ?e cho? pe?na ochrona przed zagro?eniami ze strony LLM (Large Language Models) jest trudna, kluczowe jest monitorowanie i kontrolowanie ich wykorzystania przez pracownik�w. Firmy powinny tak?e inwestowa? w narz?dzia, kt�re pomog? wykrywa? potencjalne zagro?enia p?yn?ce z korzystania z mniej znanych rozwi?za?.

Co dalej z rozwojem AI?

DeepSeek nie b?dzie ostatnim modelem, kt�ry zaskoczy rynek. W miar? rosn?cego zapotrzebowania na tanie i efektywne rozwi?zania AI, kolejne technologie b?d? pojawia? si? w b?yskawicznym tempie. Jednak historia DeepSeek przypomina, ?e za innowacj? cz?sto kryj? si? zagro?enia, kt�re mog? wp?yn?? nie tylko na cyberbezpiecze?stwo firm, ale tak?e na globalny krajobraz technologiczny.

Organizacje, kt�re chc? wdra?a? AI, musz? podej?? do tego procesu ostro?nie � nie ulegaj?c wy??cznie wizji oszcz?dno?ci i wydajno?ci, ale r�wnie? dbaj?c o bezpiecze?stwo danych i zgodno?? z regulacjami. Wy?cig o dominacj? w sektorze AI trwa, ale tylko te firmy, kt�re znajd? balans mi?dzy innowacj? a ochron?, b?d? w stanie skutecznie wykorzysta? potencja? nowych technologii.